专栏名称: 人工智能头条

| 专注人工智能技术前沿、实战技巧及大牛心得。 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

爱可可-爱生活 · 【ai-cli-lib: 为任意基于 ...· 2 天前 |

|

爱可可-爱生活 · 【使用 OpenAI Functions ...· 2 天前 |

|

宝玉xp · 转发微博-20240422135404· 2 天前 |

推荐文章

|

宝玉xp · 转发微博-20240422135404 2 天前 |

|

南商笔记 · 同力协契,学在南商 | 商小宝训练营第二期内训总结 5 月前 |

|

腾讯证券 · 港股收评:恒指重挫660点,恒生科指杀跌5%,汽车股领跌 2 年前 |

|

哲学人 · 杜兰特:生命的悲剧在于,偷走青春才赐予智慧 3 年前 |

|

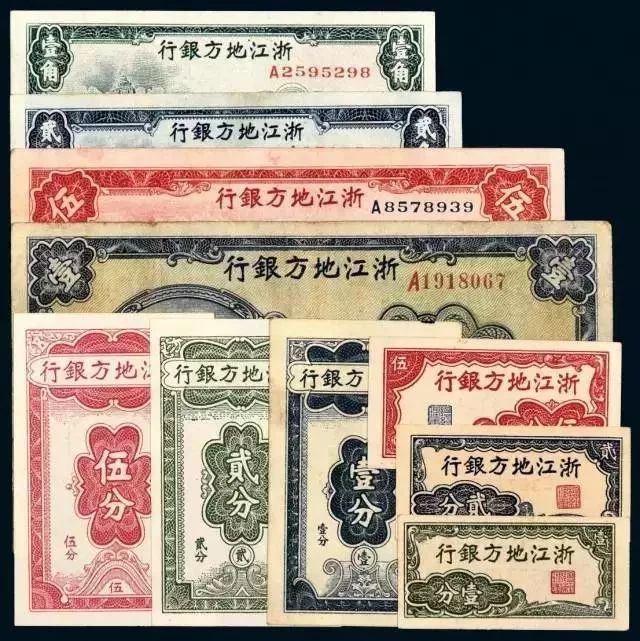

芙蓉钱币 · 最贵的钱币是哪枚?30个中国钱币之最,你知道几个? 4 年前 |