专栏名称: 算法与数学之美

| 从生活中挖掘数学之美,在实践中体验算法之奇,魅力旅程,从此开始! |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

算法(微博搜索) · 算法(微博搜索)-20240418-2· 昨天 |

|

算法(微博搜索) · 算法(微博搜索)-20240418-1· 昨天 |

|

算法(微博搜索) · 算法(微博搜索)-20240415-3· 4 天前 |

|

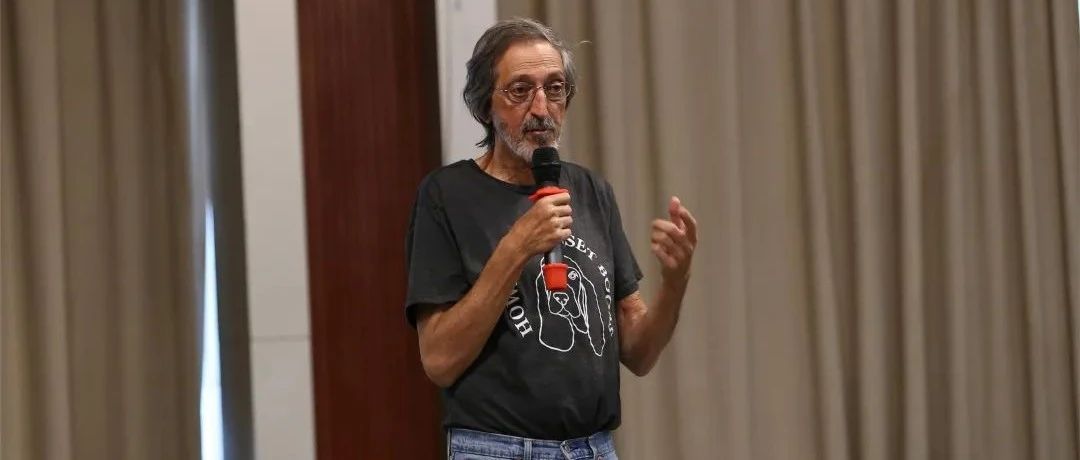

算法爱好者 · 刚刚,图灵奖揭晓!史上首位数学和计算机最高奖 ...· 1 周前 |