专栏名称: AIforResearch

| 每天分享最新最热的Arxiv论文、一起来关注大模型、AIGC、AGI |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

简单心理 · 童年期「情感忽视」究竟是什么?· 昨天 |

|

京师心理大学堂 · 【招生简章】北京师范大学心理学部2024年心 ...· 3 天前 |

|

武志红 · 你的心防有多重?一分钟测出你内心深处的“面具”· 2 天前 |

|

壹心理 · 从小不被认可的人,如何摆脱自我设限?· 2 天前 |

|

武志红 · 休息,是一项需要培养的技能· 5 天前 |

今天看啥

›

专栏

›

AIforResearch

1000万token大海寻针:递归记忆法找到了大模型忽略的内容 | 指令多样性是任务泛化的关键 | 用小模型为大模型选择微调数据

AIforResearch · 公众号 · · 2024-02-19 17:19

推荐文章

|

简单心理 · 童年期「情感忽视」究竟是什么? 昨天 |

|

武志红 · 你的心防有多重?一分钟测出你内心深处的“面具” 2 天前 |

|

壹心理 · 从小不被认可的人,如何摆脱自我设限? 2 天前 |

|

武志红 · 休息,是一项需要培养的技能 5 天前 |

|

北部战区总医院 · 雷锋精神 煋火相传|学雷锋专家医疗队上门送温暖 1 年前 |

|

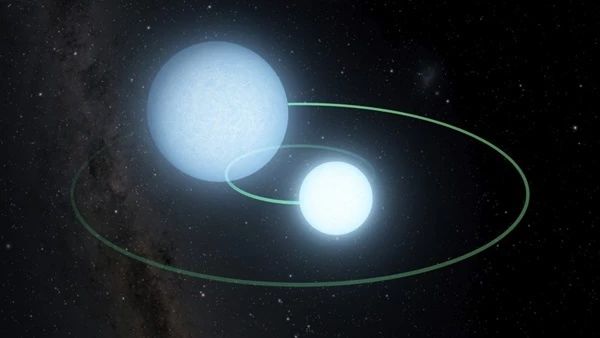

牧夫天文 · 真·陀螺 六分钟互相环绕一圈的双白矮星 4 年前 |

|

捡书姑娘 · 王鹤棣、唐嫣、赵丽颖……竟然都曾是空乘专业? 4 年前 |

|

财联社 · 【音频版】财联社10月25日早报(周四) 5 年前 |