专栏名称: 机器学习算法与自然语言处理

| 一个有情怀的公众号。机器学习、自然语言处理、算法等知识集中营、期待与你相遇~ |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

下厨房 · 口苦口干吃不下?随手一煮鲜炸天,加上这灵魂一 ...· 23 小时前 |

|

每天学点做饭技巧 · 今天才知道,原来螨虫最怕它,简单又迅速,比太 ...· 2 天前 |

|

润农畜牧报价 · 2024年4月20日 ...· 3 天前 |

|

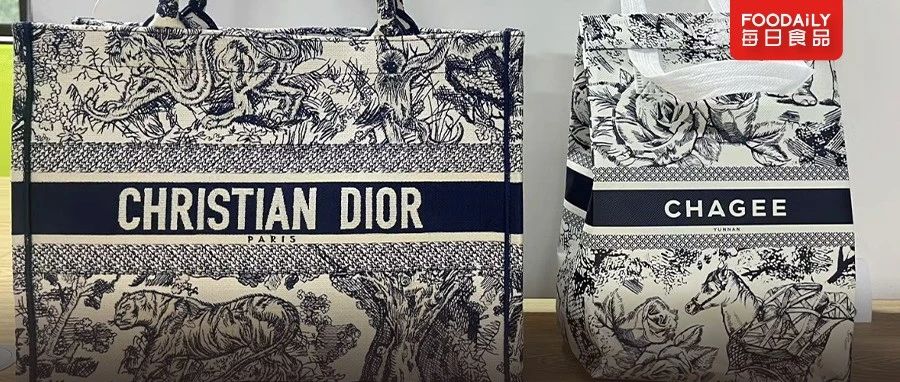

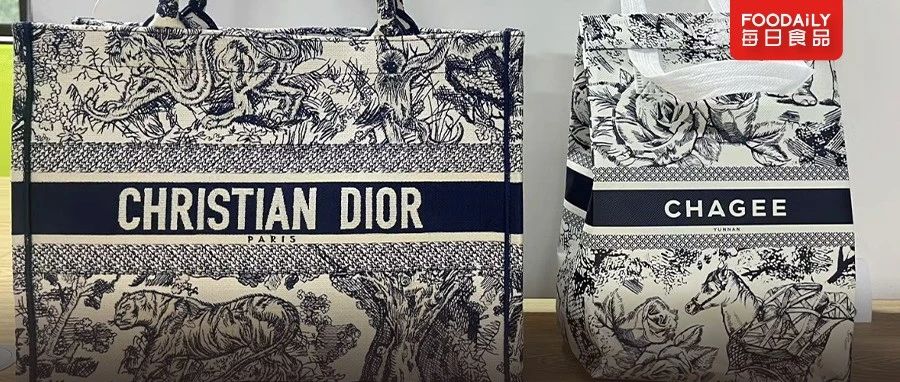

Foodaily每日食品 · 奶茶界的霸王茶姬,凭什么让迪奥白干?· 6 天前 |

|

艾格吃饱了 · 餐 厅 坟 墓 广 告.pdf· 1 周前 |

推荐文章

|

下厨房 · 口苦口干吃不下?随手一煮鲜炸天,加上这灵魂一步,绝杀外卖和餐厅! 23 小时前 |

|

Foodaily每日食品 · 奶茶界的霸王茶姬,凭什么让迪奥白干? 6 天前 |

|

艾格吃饱了 · 餐 厅 坟 墓 广 告.pdf 1 周前 |

|

中华书局1912 · 孙机:写作《汉代物质文化资料图说》一书之源起 10 月前 |

|

Charles学投资 · 转发-20210610175907 2 年前 |

|

南昌发布 · 一部视频,让你了解企业事中事后监管如何改革 5 年前 |

|

千帆育儿网 · 『教育杂谈』学习是一件快乐的事(2) 6 年前 |