专栏名称: PaperWeekly

| PaperWeekly是一个推荐、解读、讨论和报道人工智能前沿论文成果的学术平台,致力于让国内外优秀科研工作得到更为广泛的传播和认可。社区:http://paperweek.ly | 微博:@PaperWeekly |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

国际新闻界 · 《国际新闻界》荣获“新闻学与传播学最受欢迎期 ...· 9 小时前 |

|

实验万事屋 · 这华中科技大学发的5.5分接收迅速的Q2杂志 ...· 2 天前 |

|

期刊投稿指南 · 知名歌手胡海泉,出任高校院长· 5 天前 |

|

研之成理 · 上海大学王亮/南洋理工刘政、Yeng ...· 5 天前 |

推荐文章

|

国际新闻界 · 《国际新闻界》荣获“新闻学与传播学最受欢迎期刊”称号 9 小时前 |

|

期刊投稿指南 · 知名歌手胡海泉,出任高校院长 5 天前 |

|

聚焦高碑店 · 高碑店地区工委书记顾洪涛一行到半壁店村产业园区展开调研 1 年前 |

|

老子道德经 · 内心强大的人,早就戒掉了情绪 3 年前 |

|

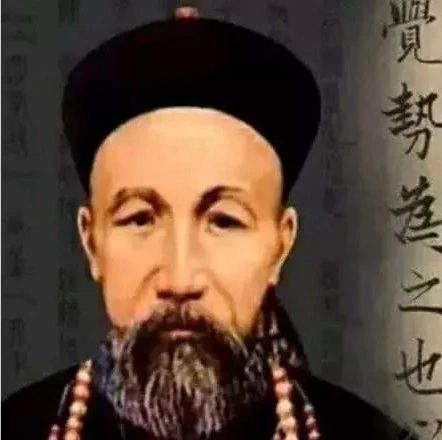

经济学杂谈 · 曾国藩的7次科举之痛,教会他2个字 4 年前 |