专栏名称: AI科技大本营

| 迎来到AI科技大本营。这里汇集了优秀的AI学习者,技术大咖和产业领袖;提供接地气的实战课程。在这里和优秀的人一起成长。 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

人工智能那点事 · 美西方指责中国“产能过剩”违背事实和产业逻辑· 2 天前 |

|

机器之心 · 当前最强国产Sora!清华团队突破16秒长视 ...· 2 天前 |

|

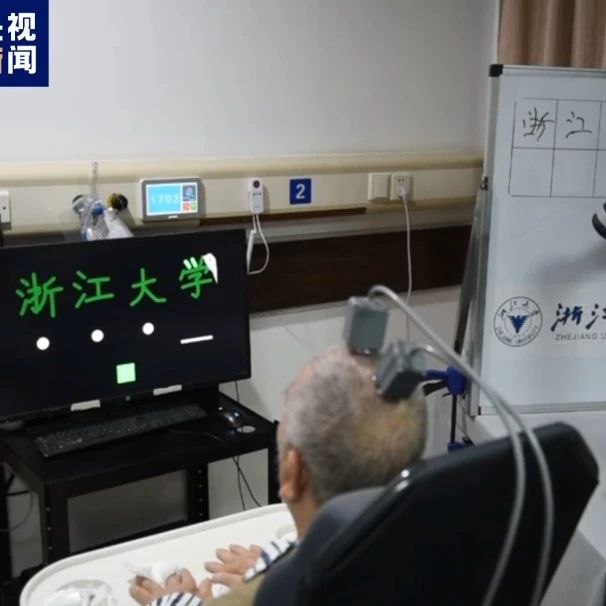

人工智能那点事 · 用意念写字?这所大学做了一件大事· 5 天前 |

|

爱可可-爱生活 · 今日推介(第1385期):多模态自动可解释性 ...· 6 天前 |

推荐文章

|

人工智能那点事 · 美西方指责中国“产能过剩”违背事实和产业逻辑 2 天前 |

|

人工智能那点事 · 用意念写字?这所大学做了一件大事 5 天前 |

|

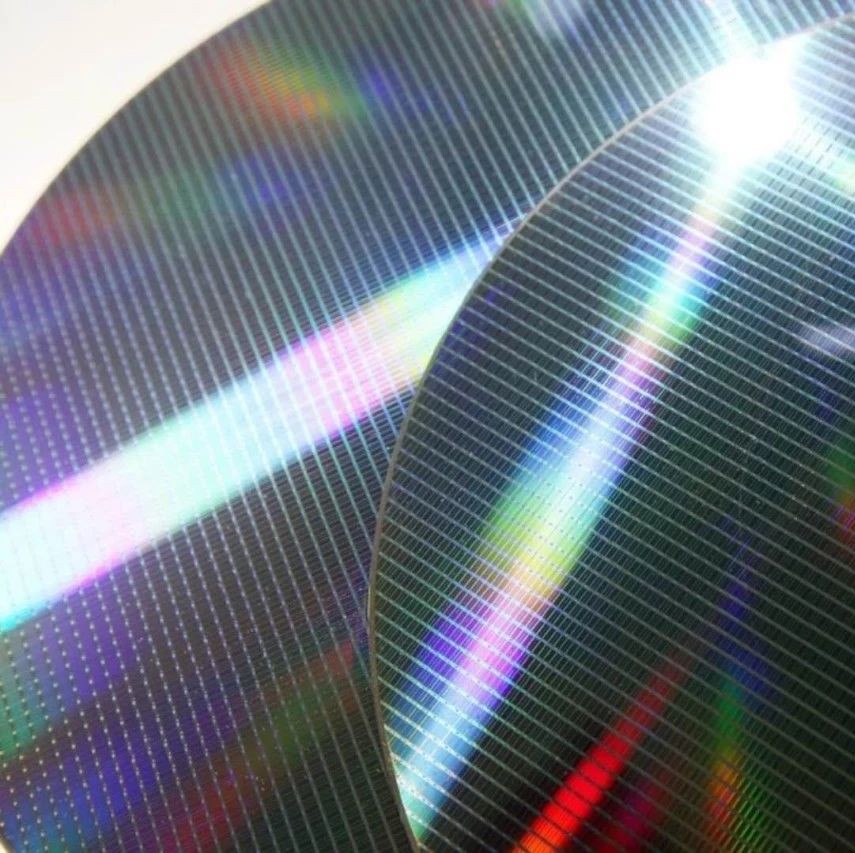

集成电路园地 · 台积8寸晶圆稼动率松动供应链出现杂音 5 年前 |

|

IPRdaily · 二三线城市「专利律师助理」如何快速成长? 6 年前 |