专栏名称: 机器之心

| 专业的人工智能媒体和产业服务平台 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

爱可可-爱生活 · 【General:高性能数据探查器,能使用各 ...· 5 天前 |

|

爱可可-爱生活 · 【Penzai:基于 JAX ...· 5 天前 |

|

黄建同学 · Harper ...· 5 天前 |

|

爱可可-爱生活 · [CL] Exploring the ...· 5 天前 |

|

宝玉xp · //@西雅图黄都督://@郑峻://@鱼姜: ...· 6 天前 |

推荐文章

|

雪球 · 又一只神基!扒扒它赚钱的秘密 1 年前 |

|

星嘉坡眼 · 汇率持续走高,新加坡外汇交易迎来入市新机遇 1 年前 |

|

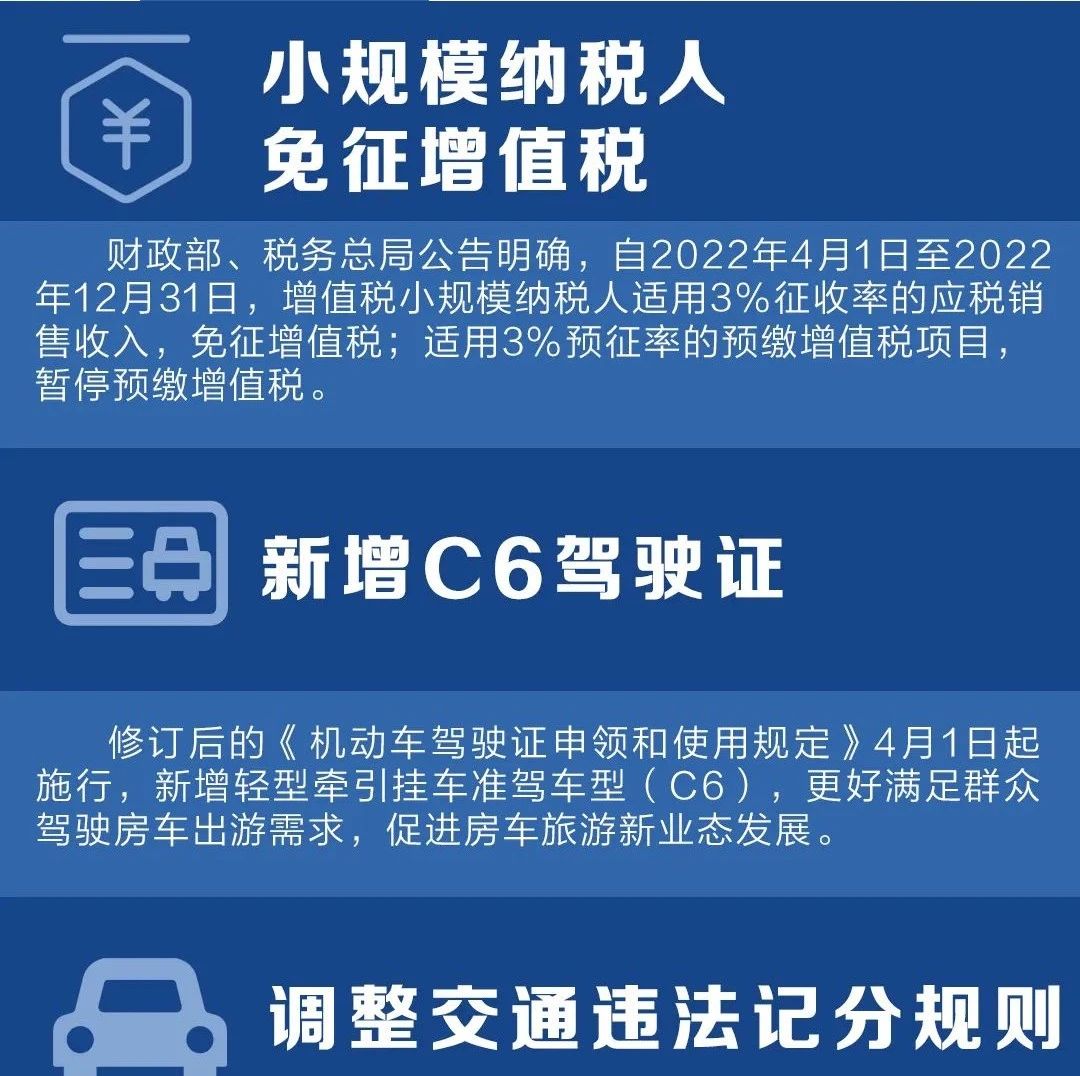

广西日报 · 明天起,这些新规将影响你的生活 2 年前 |

|

纪念币大百科 · 鼠币兑换2天兑走1.1亿枚,价格大跌,你还兑换吗? 4 年前 |

|

推软妹君 · 曾经女主播一姐,如今无人知晓! 5 年前 |