专栏名称: PaperWeekly

| PaperWeekly是一个推荐、解读、讨论和报道人工智能前沿论文成果的学术平台,致力于让国内外优秀科研工作得到更为广泛的传播和认可。社区:http://paperweek.ly | 微博:@PaperWeekly |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

弗雷赛斯 · 原来差异分析图,还能这么高级!· 4 天前 |

|

小张聊科研 · 生信火了十多年了,现在生信发文需要注意些什么?· 6 天前 |

|

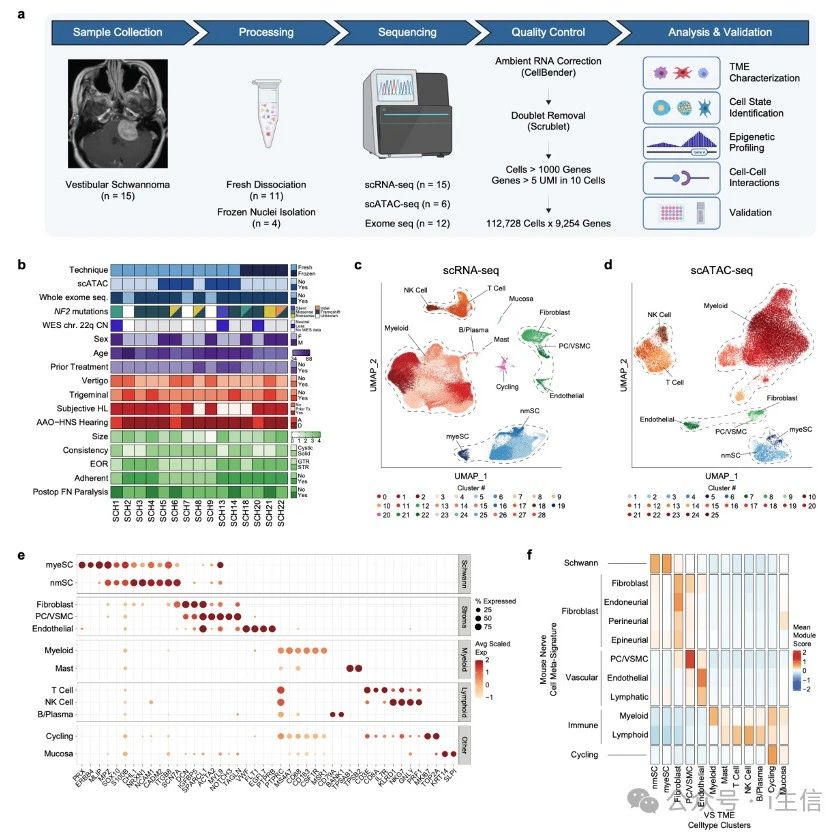

小张聊科研 · 华盛顿大学这篇单细胞多组学NC文章,做的是肿 ...· 4 天前 |

|

PaperWeekly · CVPR 2024 | ...· 6 天前 |

|

社会学理论大缸 · 24Fall录取结果:数十位学生斩获牛津、剑 ...· 5 天前 |

今天看啥

›

专栏

›

PaperWeekly

NAACL 2024 | 阿里提出大语言模型对齐框架Reward Learning on Policy (RLP)

PaperWeekly · 公众号 · 科研 · 2024-04-16 18:09

推荐文章

|

弗雷赛斯 · 原来差异分析图,还能这么高级! 4 天前 |

|

小张聊科研 · 生信火了十多年了,现在生信发文需要注意些什么? 6 天前 |

|

IPO在线 · 解读:股权投资的30个概念!!! 1 年前 |

|

杭州日报 · 假期余额不足,并不可怕!其实春节最残忍的真相是…… 7 年前 |