专栏名称: 中国人工智能学会

| 关注中国人工智能学会官方公共账号,收取学会的科普信息、新闻动态、活动预告及人工智能领域科技前沿信息。 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

黄建同学 · 这个项目对于AI方面的知识学习、面试很有用↓ ...· 2 天前 |

|

爱可可-爱生活 · 'Dockerized Signal ...· 3 天前 |

|

黄建同学 · 发现一个比较有创意的AI大模型交互flowi ...· 4 天前 |

|

爱可可-爱生活 · 几篇论文实现代码:《Real ...· 4 天前 |

|

新智元 · 北大图灵班00后学子夺得五金!北大荣获国际大 ...· 5 天前 |

今天看啥

›

专栏

›

中国人工智能学会

CMU和谷歌联手放出XL号Transformer!提速1800倍 | 代码+预训练模型+超参数

中国人工智能学会 · 公众号 · AI · 2019-01-16 12:22

推荐文章

|

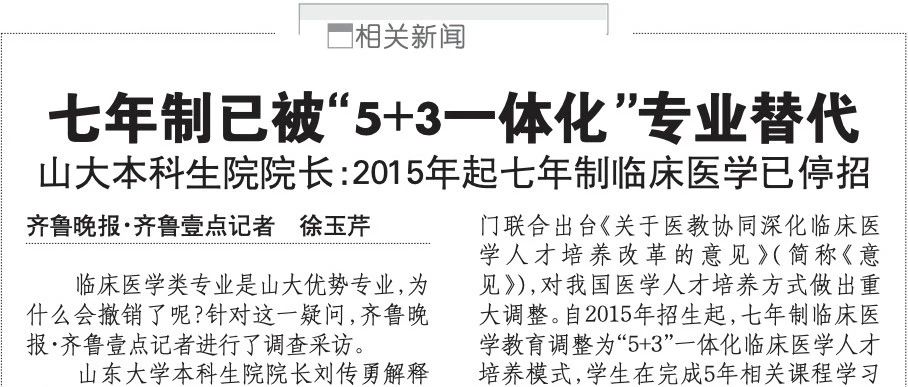

医学生 · 这个专业有变,未撤销…高校回应 3 年前 |

|

时尚先生 · 一份《中国辣椒报告指南》等你领取 4 年前 |

|

新微设计 · 不丹,竟藏着这么多世界顶级酒店... 4 年前 |

|

胡阿小小 · 胡阿小小-6614398725039066382 5 年前 |

|

运营控 · 揭秘:支付宝年账单为什么这么准?刷屏年度关键词解密 6 年前 |