专栏名称: GiantPandaCV

| 专注于机器学习、深度学习、计算机视觉、图像处理等多个方向技术分享。团队由一群热爱技术且热衷于分享的小伙伴组成。我们坚持原创,每天一到两篇原创技术分享。希望在传播知识、分享知识的同时能够启发你,大家一起共同进步(・ω<)☆ |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

今天看啥

›

专栏

›

GiantPandaCV

漫谈 KV Cache 优化方法,深度理解 StreamingLLM

GiantPandaCV · 公众号 · 3D · 2023-12-02 23:07

推荐文章

|

GiantPandaCV · CUDA-MODE 第一课课后实战(下) 1 周前 |

|

潇湘晨报 · 小伙跟女友吵架吞下2根铁丝穿透小肠!去年曾吞下6根…… 1 年前 |

|

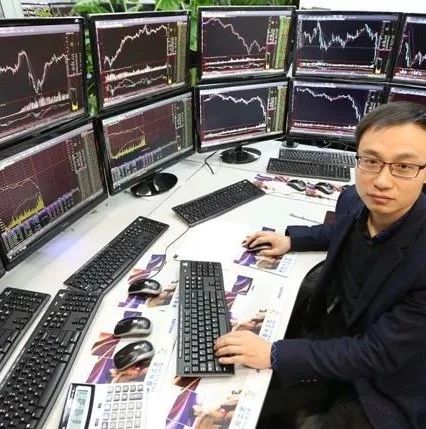

量化与对冲 · 期货期权日内核心技术特训营(第四期) 4 年前 |

|

宠物扒 · 金毛每天在警察局门口“蹭吃蹭喝”,警察叔叔们居然还很感动? 4 年前 |

|

电影铺子 · 豆瓣8.8,春宵苦短要珍惜 6 年前 |