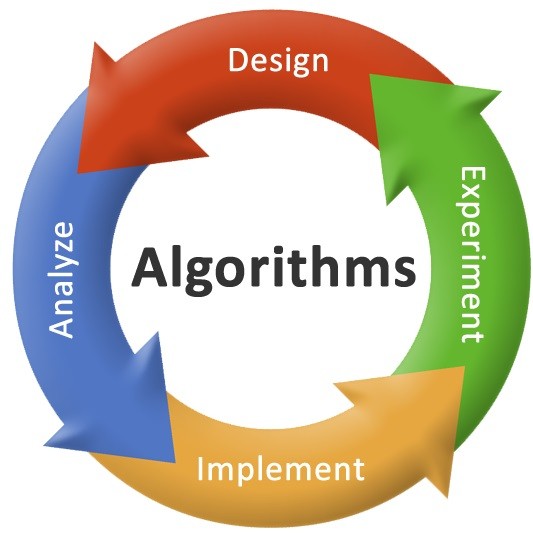

专栏名称: 算法与数据结构

| 算法与数据结构知识、资源分享 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

九章算法 · 真看不懂 Meta…· 昨天 |

|

九章算法 · 死磕算法不如另辟蹊径!System ...· 昨天 |

|

九章算法 · K.O大厂“原题”的《OOD面向对象圣经》, ...· 2 天前 |

|

九章算法 · 22岁小红书网红进Google,一问转码才半 ...· 3 天前 |

|

九章算法 · 秋招提前抄底价!「2024课程通关年卡」紧急 ...· 4 天前 |

推荐文章

|

九章算法 · 真看不懂 Meta… 昨天 |

|

九章算法 · K.O大厂“原题”的《OOD面向对象圣经》,开放下载! 2 天前 |

|

九章算法 · 22岁小红书网红进Google,一问转码才半年... 3 天前 |

|

房屋装修百科 · 餐厅这样设计,1㎡当2㎡用不浪费! 1 年前 |

|

自然系列 · “Nature自然科研”招人啦! 3 年前 |

|

简乐l · 【低风险创业训练营】降低边际成本,撬动杠杆资源 3 年前 |

|

特色小镇研究院 · 农村集体经营性建设用地入市的关键问题与制度设想 5 年前 |