专栏名称: AINLP

| 关注AI、NLP相关技术,关注算法研发职位和课程;回复"文章"获取历史信息;双语聊天机器人"无名";中英翻译请输入:翻译 翻译内容;自动对联,请输入:上联 上联内容;调戏夸夸聊天机器人,请求夸、求赞;查询相似词,请输入: 相似词 词条 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

InfoQ架构头条 · AI大模型如何在各行业跑通业务闭环?· 3 天前 |

|

运维 · 华为将鸿蒙操作系统推向全球· 3 天前 |

|

运维 · 华为《Kubernetes学习笔记》太强了, ...· 3 天前 |

|

InfoQ架构头条 · “烧钱”的大模型如何为企业“降本增效”助力? ...· 6 天前 |

|

运维 · 局域网内终端是如何访问外网?答案在最后· 5 天前 |

推荐文章

|

InfoQ架构头条 · AI大模型如何在各行业跑通业务闭环? 3 天前 |

|

运维 · 华为将鸿蒙操作系统推向全球 3 天前 |

|

运维 · 局域网内终端是如何访问外网?答案在最后 5 天前 |

|

果壳 · 天仙也逃不过的耳洞发炎,到底怎么解决? 1 年前 |

|

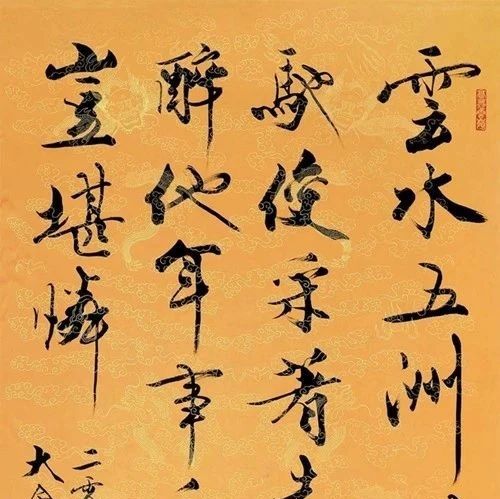

芝麻开门收藏网 · 范曾的书法究竟算不算艺术?有没有收藏价值? 3 年前 |

|

吴晓波频道 · 用上这三句话,你就在搞定客户上“开了挂” | 今晚直播 4 年前 |