专栏名称: PaperWeekly

| 欢迎关注同名微信公众号:PaperWeekly |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

实验万事屋 · 这南京大学和中山大学发的44.1分的Cell ...· 3 天前 |

|

募格学术 · 【仅剩12小时】硕博入门必学!研究生需要掌握 ...· 3 天前 |

|

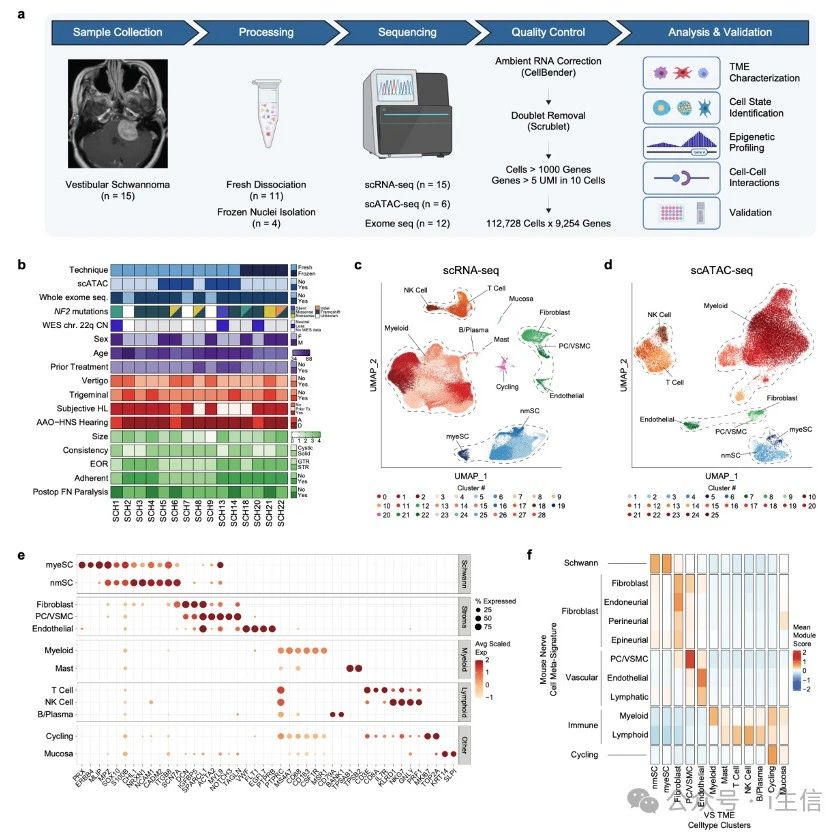

小张聊科研 · 华盛顿大学这篇单细胞多组学NC文章,做的是肿 ...· 3 天前 |

|

研之成理 · 常压合成钻石,Nature!· 3 天前 |

|

实验万事屋 · 这复旦大学发的10.6分综述,他讲了中性粒细 ...· 5 天前 |

推荐文章

|

研之成理 · 常压合成钻石,Nature! 3 天前 |

|

生意人 · 真正厉害的人,都避开了“巴纳姆效应” 2 年前 |

|

腾讯技术工程 · 从生物学的角度浅谈前端工程化 4 年前 |

|

全球风口 · 你只看到了中美贸易战,其实背后是一场科技军备竞赛! 5 年前 |