专栏名称: 机器学习算法与自然语言处理

| 一个有情怀的公众号。机器学习、自然语言处理、算法等知识集中营、期待与你相遇~ |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

于小戈 · 下嫁吃屎,还被家暴。· 昨天 |

|

于小戈 · 妈呀!在高铁上发现了一个秘密· 5 天前 |

|

于小戈 · 闺蜜竟然让我干这种事...· 5 天前 |

|

情侣ins头像 · 情头 | 想和我坠爱滴宝宝换情头· 5 天前 |

推荐文章

|

于小戈 · 下嫁吃屎,还被家暴。 昨天 |

|

于小戈 · 妈呀!在高铁上发现了一个秘密 5 天前 |

|

于小戈 · 闺蜜竟然让我干这种事... 5 天前 |

|

情侣ins头像 · 情头 | 想和我坠爱滴宝宝换情头 5 天前 |

|

Python入门到精通 · 八十六、从拓扑排序探究有向图 3 年前 |

|

果壳 · 疫情之下,我们在上海的八十个探头,监测着城市野生动物 4 年前 |

|

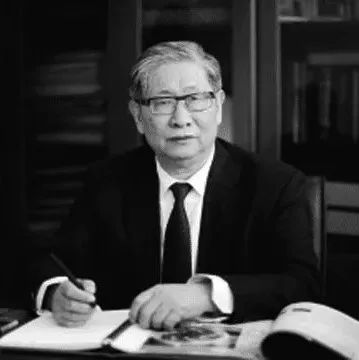

生物探索 · 刘昌孝院士:全球生物医药研发多点开花 6 年前 |