专栏名称: 机器之心

| 专业的人工智能媒体和产业服务平台 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

机器之能 · 开源大模型Llama ...· 昨天 |

|

机器之心 · 首个国产音乐SOTA模型来了!专为中文优化, ...· 2 天前 |

|

宝玉xp · 还好这几个我都没尬吹过-2024041609 ...· 4 天前 |

|

宝玉xp · 福布斯发布2024年人工智能初创企业50强随 ...· 5 天前 |

|

爱可可-爱生活 · 【收集了基于 ...· 5 天前 |

推荐文章

|

宝玉xp · 还好这几个我都没尬吹过-20240416093137 4 天前 |

|

THLDL领导力 · 央视爆料;全是假货,没有一件真品! 4 年前 |

|

周国平 · 父母的眼界,决定孩子未来的高度 5 年前 |

|

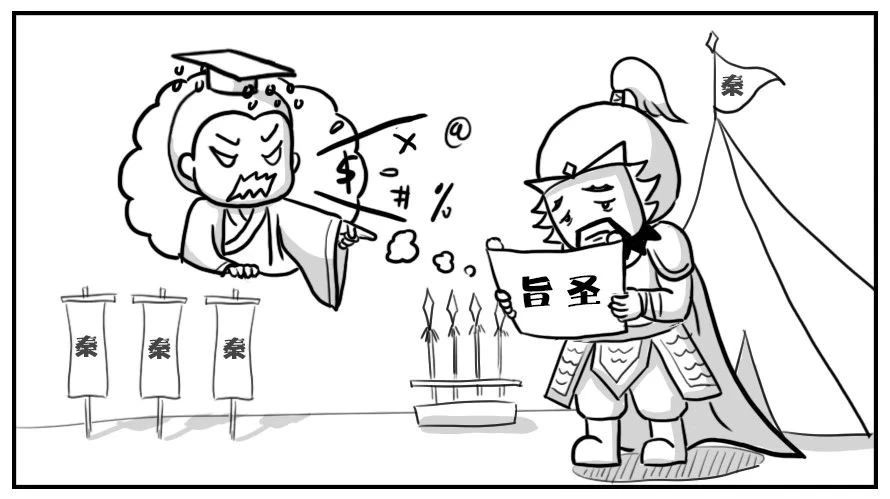

闻古知新 · 楚汉系列丨来自咸阳的责难 5 年前 |