专栏名称: 桃子说产品

| AI产品专家 个人网站:https://ww... |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

收获 · 《收获》微信专稿 | 《淑女》: ...· 13 小时前 |

|

为你读诗 · 迷茫时读《孙子兵法》,破解人生僵局· 3 天前 |

|

为你读诗 · 焦虑时,读一读哲学,很有必要· 5 天前 |

|

为你读诗 · 我跋山涉水,为了抵达自己 | 为你读诗· 5 天前 |

|

文汇学人 · 节气 |天未大热,乐享小满· 1 周前 |

推荐文章

|

收获 · 《收获》微信专稿 | 《淑女》: 所谓淑女,于变局中温和地做自己(吴玫) 13 小时前 |

|

为你读诗 · 迷茫时读《孙子兵法》,破解人生僵局 3 天前 |

|

为你读诗 · 焦虑时,读一读哲学,很有必要 5 天前 |

|

为你读诗 · 我跋山涉水,为了抵达自己 | 为你读诗 5 天前 |

|

文汇学人 · 节气 |天未大热,乐享小满 1 周前 |

|

明河投资 · 海上潮声 | 20230303 1 年前 |

|

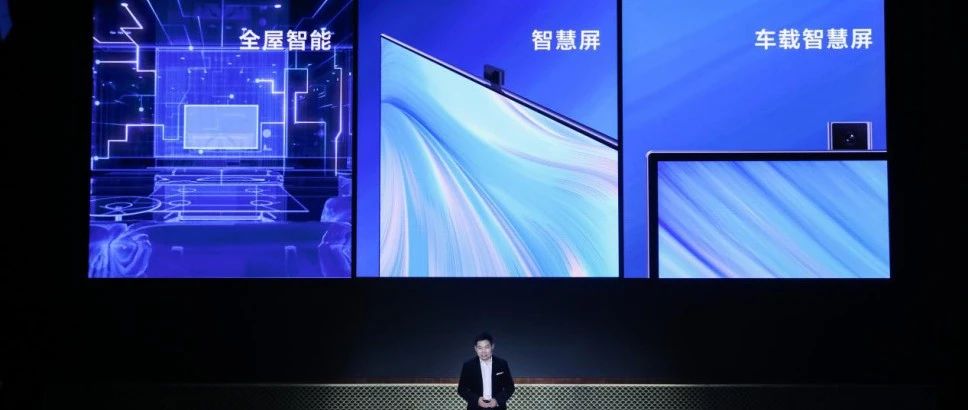

万能的大熊 · 从底层重塑真智能家居,华为发布全屋新方案 3 年前 |

|

一更历史 · 演员许凯穿明朝汉服惹争议,韩国人却硬说这是韩服,真可笑 3 年前 |

|

淘股吧 · 中美MY谈判无功而返,大盘还能涨吗? 5 年前 |